DIE ZEIT/Feuilleton, Nr.43, 18.Oktober 1974, S.25-26

Titel: »Der große Streit um die Intelligenz (II) ‒ Was IQ-Tests messen: Eine unerklärte und undefinierte und dennoch faßbare und reale Größe«

© 1974 DIE ZEIT und Dieter E. Zimmer

Die IQ-Kontroverse, 1974

II

Von Dieter E. Zimmer

WEN DER STREIT um die Erblichkeit der Intelligenzunterschiede alarmiert, wird als erstes einige berechtigte Fragen aufwerfen: Was messen Intelligenztests überhaupt? Spielt das, was sie messen, im Leben irgendeine Rolle? Welche Rolle? Und was überhaupt heißt hier Intelligenz?

Denn wenn sich herausstellen sollte, daß die Testpsychologen einem Phantom nachsetzen und die von ihnen Intelligenz genannte Eigenschaft im Leben ohne wirkliche Bedeutung ist, könnte man sich den Rest der Kontroverse gut und gern schenken. Jeden, der einmal einen Intelligenztest gemacht hat, zum Beispiel die spielerischen IQ-Tests in dem Buch von Hans Jürgen Eysenck, wird der Verdacht befallen haben, hier werde keineswegs gemessen, was man im allgemeinen Sprachgebrauch unter Intelligenz versteht, sondern irgendeine spezielle Fähigkeit: etwa die, Rätsel zu raten oder Codes zu dechiffrieren; so daß die Testergebnisse vielleicht Aussägen darüber machen, ob einer sich für die Agentenlaufbahn eignet, aber sonst über so gut wie nichts.

Das Wort intelligentia wurde von Cicero erfunden, als er eine lateinische Entsprechung zu Aristoteles' Begriff der dia-noesis suchte: für die menschliche Fähigkeit, Gefühle und Willen vernünftig zu steuern. Neubelebt wurde der Begriff erst wieder von dem englischen Philosophen Herbert Spencer (1820-1903), der damit die Fähigkeit bezeichnete, "innere Beziehungen den äußeren anzupassen". Es war und blieb vorläufig ein gelehrtes Fachwort. Erst in den letzten sechzig Jahren drang es in die Umgangssprache ein. Der englische Psychologe Sir Cyril Burt verteidigte sich und seine Kollegen noch 1968 gegen den Vorwurf, sie hätten der Umgangssprache ein Wort entwendet, um ihm einen stark verengten Sinn unterzuschieben. Im Gegenteil: die Umgangssprache hatte sich einen psychologischen Spezialbegriff angeeignet und ihn bis zur Bedeutungslosigkeit ausgeweitet. Freuds "Komplex" erging es ähnlich.

Eine Definition der Intelligenz steht bisher aus. Es gibt nur mehr oder weniger ungefähre Annäherungen. Der englische Psychologe Charles E. Spearman (1863-1945) definierte Intelligenz gelehrt als "Fähigkeit, Beziehungen und Korrelate abzuleiten". Arthur Jensen, einfacher, begnügt sich mit dem "Vermögen, abstrakt zu denken und Probleme zu lösen". Was Wärme ist, kann die Physik heute erklären (obwohl sie Temperaturen auch schon maß, als sie Wärme noch nicht erklären konnte); was Intelligenz eigentlich "ist", wissen Psychologie und Physiologie nicht. Sie läßt sich nicht direkt beobachten. Beobachten lassen sich nur verschiedene Verhaltensweisen vieler Menschen in verschiedenen Situationen, und in diesem Verhalten lässt sich schließlich nach einem gemeinsamen Faktor suchen, der die Bezeichnung Intelligenz verdient. Trotzdem, es scheint, die Testpsychologen haben da etwas zwar Undurchschautes, aber dennoch Reales im Griff. Diese Größe isoliert zu haben und relativ genau messen zu können, halten manche Psychologen für die bisher größte Tat ihrer Wissenschaft überhaupt.

Der Begründer aller Intelligenzvermessung ist Darwins unruhiger Cousin Sir Francis Galton (1822-1911): Entdeckungsreisender, Journalist, Mathematiker, Meteorologe. Als Kriminologe hat er die Wissenschaft von den Fingerabdrücken begründet. Von ihm stammt das Wort 'Eugenik': Zeitlebens beschäftigte ihn die Frage, was manche Menschen zu genialen geistigen und schöpferischen Leistungen befähige und wie man diese Fähigkeiten vermehren könne. Galton glaubte, Intelligenz habe etwas mit der Schärfe und Schnelligkeit des Wahrnehmungsvermögens zu tun: mit dem Vermögen etwa, leichte Gewichts-, Ton- oder Temperaturunterschiede zu registrieren. In dieser Richtung suchte er. Zeitweise betrieb er in einem Londoner Museum ein Labor, in dem man gegen Gebühr Wahrnehmungsvermögen und Reaktionsgeschwindigkeit testen lassen konnte. Wie sich zeigte, war es ein falscher Ansatz.

Den nächsten Schritt tat der französische Psychologe Alfred Binet (1857-1911). Er stand vor einer durch und durch praktischen Aufgabe: Der französische Erziehungsminister hatte ihn beauftragt, eine objektive (nämlich nicht auf Lehrerimpressionen angewiesene) und praktikable Methode zu entwickeln, frühzeitig schwachbegabte Kinder zu identifizieren; sie sollten in Sonderschulen geschickt werden. Binet und sein Mitarbeiter Henri Simon sahen schon 1895, daß die Beobachtung von sensorischen und motorischen Funktionen sie nicht weiterbrachte. Von der Annahme ausgehend, daß Intelligenz eine Eigenschaft an sich sei, beobachteten sie zehn Jahre lang, welche Art Aufgaben von Lehrern gestellt wurden, brachten die Beobachtungen in ein System, erfanden und verwarfen Testaufgaben aus verschiedenen Gebieten, die irgendwie mit Denken verbunden zu sein schienen.

1905 legten sie dann die erste Meßskala für die Intelligenz vor. Sie ist, mehrfach bearbeitet vor allem durch den Stanforder Psychologen Lewis Terman, als Stanford-Binet-Test noch heute in Gebrauch und neben Wechsler's Intelligence Scale der verbreitetste Intelligenztest überhaupt. Terman war auch der Urheber eines der größten und kuriosesten Forschungsvorhaben, die je ein Psychologe unternommen hat. Er suchte sich 1922 die über 1500 höchstbegabten kalifornischen Kinder - ihr Durchschnitts-IQ lag bei 150 ‒ und verfolgte ihre Lebensläufe fast vierzig Jahre lang. Die Ergebnisse sind in den fünf Bänden seines Werks Genetic Studies of Genius festgehalten. Eine hohe gemessene Intelligenz, so stellte sich heraus, ist auch auf die Dauer viel wert und beschert seinem Besitzer Karrieren von überdurchschnittlichem Prestigewert.

Binets Test war der erste, der "standardisiert" wurde: Jedes individuelle Testergebnis bezog sich auf einen für die Gesamtheit gültigen Mittelwert. Das heißt, durch praktische Erprobung wurden seine Aufgaben so eingerichtet, daß sie fortlaufend schwieriger wurden und genau die Hälfte der Probanden nicht mehr als die Hälfte der Aufgaben bewältigte. Jedem individuellen Testergebnis fiel damit ein Platz auf einer Meßskala zu; Intelligenz stellte sich als Kontinuum dar, nicht als etwas, das entweder da ist oder fehlt.

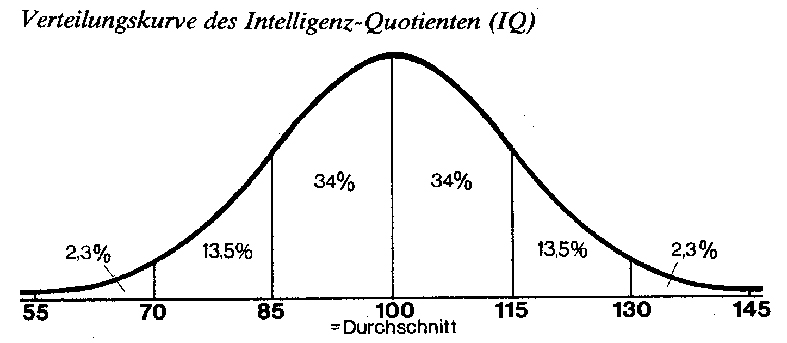

Und zwar ging Binet von der (mit letzter Sicherheit nicht beweisbaren) Annahme aus, daß die Intelligenz in der Bevölkerung nach der Gaußschen "Normalkurve" verteilt sei, ähnlich wie andere menschliche Merkmale, die Körpergröße zum Beispiel. Die Normalkurve zeigt, wie bei Merkmalen, die von verschiedenen, unabhängig voneinander wirkenden Faktoren hervorgerufen werden, Mittelwerte viel häufiger eintreten als extreme Werte. Wirft man etwa eine Münze sehr oft hoch (je öfter, um so perfekter das Ergebnis), so wird die Folge Zahl-Kopf am häufigsten eintreten; zweimal Zahl seltener, fünfmal Zahl sehr viel seltener, zwanzigmal Zahl so gut wie nie. Stellt man diese Häufigkeiten graphisch dar, so erhält man eine glockenförmige Kurve, die links ganz unten beginnt, erst langsam, dann schneller zum Mittelwert ansteigt, sich in der Nähe des Mittelwertes abflacht und jenseits spiegelbildlich abfällt.

Fast gleich verläuft die Intelligenzkurve, die die einzelnen Standardtests erbringen. (Die größte Abweichung von ihr zeigt sich ganz unten: Es sind die Fälle organischer Hirnschäden.) Ihr Mittelwert wird mit 100 angesetzt, ihr unterer Extremwert mit 50, ihr oberer mit 150. 50 Prozent der Gruppe, für die der Test standardisiert ist, erreicht Werte zwischen 90 und 110; 25 Prozent haben eine überdurchschnittlich hohe Intelligenz (über 110), 25 Prozent eine unterdurchschnittliche (unter 90).

Der Begriff 'Intelligenzquotient' (IQ) wurde 1912 geprägt, von dem deutschen Psychologen William Stern. Es ist ein Quotient, also das Ergebnis einer Division, weil er tatsächlich eine Verhältniszahl ist: Bei Kindern in den ersten sechzehn Lebensjahren, in denen sich die Intelligenz noch entwickelt, ist er das Verhältnis des mit dem Test ermittelten Intelligenzalters zum Lebensalter, bei Erwachsenen das Verhältnis des individuellen Testergebnisses zum aktuellen kollektiven Durchschnitt.

Man muß sich also über zweierlei im klaren sein: Intelligenztests sind nicht von der Natur vorgezeichnet, sondern ein pragmatisch entwickeltes Artefakt der Psychologen ‒ ein Instrument, Testergebnisse so zu spreizen, daß die IQ-Verteilung eine Chance bekommt, mit der Normalkurve übereinzustimmen. Sie sind auch nicht allgemeingültig, sondern aus den konkreten Anforderungen einer gegebenen Zivilisation heraus entwickelt. Ein Jägerdasein im Dschungel fordert ganz andere Formen von Intelligenz als das Überleben und der Erfolg in einer Industrienation und den Schulen, die auf sie vorbereiten.

Die Psychologen nach Binet stellten sich vor allem eine Frage: Gibt es eine einzige, allgemeine Intelligenz, oder setzt sich das, was man Intelligenz nennt, aus verschiedenen unabhängigen Fertigkeiten zusammen? Hauptverfechter der Theorie von der einen, allgemeinen Intelligenz (von ihm einfach und trocken 'g' genannt, für general ability) war in den zwanziger Jahren Charles E. Spearman; sein Hauptgegner L.L. Thurstone, der in der Intelligenz zunächst ein Bündel unabhängiger "primärer intellektueller Fähigkeiten" zu sehen meinte: Raumvorstellung, Wahrnehmungsvermögen, Wortverständnis, Rechenvermögen, Gedächtnis, Sprachgeläufigkeit, induktives und deduktives logisches Denken. Es gelang jedoch nicht, Tests zu konstruieren, deren Aufgaben einerseits beanspruchen konnten, so etwas wie Intelligenz zu messen, andererseits in den Ergebnissen nicht miteinander korrelierten. Immer blieb ein Gemeinsames übrig, ein harter Kern, 'g', der bei allen Ausformungen der Intelligenz involviert ist.

Die Rivalität der Theorien von Spearman und Thurstone hat die Testmathematik um viele Finessen bereichert; am Ende erwies sich 'g' als "Felsen von Gibraltar" (Jensen). Er steht noch heute, auch wenn ein Intelligenzmodell wie J.P. Guilfords "Würfel" (1967) mit seinen drei Dimensionen "Operationen", "Produkte" und "Inhalte" die Gesamtintelligenz aus nicht weniger als 120 verschiedenen Bestandteilen zusammensetzt.

Der g-Faktor inspirierte einige Psychologen, Tests zu entwickeln, die nicht ein Sortiment verschiedenartiger Aufgaben stellten, sondern diesen allgemeinen Faktor möglichst pur zu ermitteln suchten. Das bedeutete, daß sie von erworbenem Bildungsgut ganz absahen, also zum Beispiel auf sprachliche Aufgaben völlig verzichteten. Ihre Tests sind etwa Serien von Piktogrammen, die sich nach verschiedenen Prinzipien verändern und von den Getesteten vervollständigt werden müssen ‒ wobei das Prinzip der Abwandlung von Serie zu Serie schwerer zu durchschauen ist. Diese Tests sind in der Tat nahezu "kulturneutral": Wissen, Bildung hilft den Probanden hier überhaupt nicht weiter. Nur Personen aus Kulturen, in denen zum Beispiel völlig andere Raumvorstellungen herrschen, wären von ihnen benachteiligt. Die bekanntesten Tests dieses Typs sind die "Progressive Matrices" des britischen Psychologen J.C. Raven (1938) und der "Culture Fair Intelligence Test" des Amerikaners R.B. Cattell (1959), der 1971 auch in einer standardisierten deutschen Version von Rudolf Weiß eingeführt wurde.

Cattell war es auch, der die nützliche Unterscheidung zwischen zwei Arten von Intelligenz machte: einer "flüssigen", dem reinen logisch-kombinatorischen Vermögen, das in der Jugend am größten ist und dann schwach abfällt; und einer "kristallisierten", die vor allem erworbenen Fertigkeiten anzapft und mit zunehmendem Lebensalter gewöhnlich ansteigt.

Soviel mindestens muß man wissen, wenn überhaupt verstehen will, wovon die IQ-Zunft spricht.

Sie behauptet nicht, die ganze Persönlichkeit zu beschreiben. Persönlichkeitsmerkmale wie Ausdauer, Konzentration, Ehrgeiz, Energie, Gedächtnis, Motivation, Kreativität (die Fähigkeit, sich neuartige Lösungen einfallen zu lassen und sie zu verwirklichen), Extra- und Introvertiertheit läßt sie weitgehend außer acht. Auch bei den eigentlichen intellektuellen Fähigkeiten mißt sie nur einen Ausschnitt. Moralische Kriterien ignoriert sie vollständig: Einer mag seinen hohen g-Faktor dazu benutzen, eine Bank zu managen, ein anderer, den perfekten Banküberfall zu planen, ein dritter, die dabei Verletzten ärztlich zu versorgen. Der IQ sagt nicht das mindeste darüber, wie angenehm ein Mensch für seine Mitwelt ist und wie nützlich für die Gesellschaft.

Was also messen IQ-Tests? Sie messen nicht das, was jeder für sich, in seinem privaten Sprachhaushalt, unter Intelligenz verstehen mag. Sie messen eine bisher unerklärte und undefinierte Größe, die nirgends unvermischt rein auftritt. Die beste Antwort auf die Frage, was denn die Testpsychologie unter Intelligenz verstehe, ist immer noch die: Intelligenz ist, was die IQ-Tests messen. Die Intelligenz wurde, so Liungman, nicht entdeckt, sie wurde erfunden.

Aber sie ist dennoch etwas Reales. Bei den verschiedensten intellektuellen Aufgaben spielt sie als größter isolierbarer Faktor offensichtlich eine Rolle. Es ist kein beliebiger Faktor, unvergleichlich weniger beliebig als jener, den ein Anti-Jensen-Pamphlet der American Party for Workers' Power vorschlug: Intelligent sei, wer revolutionär denke. Und in welchem Maße dieser Faktor vorhanden ist, ist nicht folgenlos. Es entscheidet wesentlich darüber mit, ob ein Mensch sich in unserer Kultur zurechtfindet oder gar reüssiert.

Der IQ ist zum einen geradezu diabolisch konstant: Stimmungen und verschiedene Testsituationen beeinflussen das Testergebnis nur geringfügig. Die normale Schwankungsbreite überschreitet 10 Punkte nach oben oder unten nicht. Wer in einem Test auf einen IQ von etwa 110 kommt, kann ziemlich sicher sein, daß er niemals weniger als 100 und mehr als 120 erreichen wird. Macht man einen gleichartigen Test mehrmals, so differieren die Testergebnisse im Durchschnitt nur um 4 Punkte. Testerfahrung verbessert die Ergebnisse um 5 bis 8, gezieltes Einpauken der Testaufgaben um 10 Punkte. Überlisten lassen sich IQ-Tests also nur in sehr engen Grenzen. Männer und Frauen zeigen keine wesentlichen Unterschiede. Was in den ersten fünf Lebensjahren gemessen wird, hat nur eine geringe Beziehung zu späteren Testergebnissen ‒ der g-Faktor entwickelt sich erst später. Wenn er sich aber mit dem fünfzehnten Lebensjahr einmal ausgebildet hat, bleibt er ganze Leben über nahezu gleich.

Zur Konstanz kommt die prognostische Kraft. Entwickelt wurden die ersten Tests mit dem praktischen Ziel, Schulleistungen vorherzusagen ‒ und es ist kein anderer einzelner Faktor entdeckt worden, der für die Schulleistung annähernd so bedeutsam wäre wie der IQ. Da die Schulleistung wiederum in Beziehung zu dem späteren Erfolg im Leben steht, bestimmt der IQ auch diesen erheblich mit. Eine gängige Schätzung für die Beziehung zwischen IQ und Schulleistung besagt, daß er für rund 50 Prozent der Leistungsunterschiede verantwortlich ist. Psychologen wie Jensen, Herrnstein und Eysenck nennen das eine hohe Korrelation; Jencks, in seinem Buch Chancengleichheit, eine niedrige. Natürlich kann man beides sagen, so wie man ein halb gefülltes Glas halb voll oder halb leer nennen mag.

Die Korrelation zwischen IQ und Erfolg im Beruf ist niedriger: Die Unterschiede im Berufserfolg lassen sich nur zu 25 Prozent aus Intelligenzunterschieden erklären.

Klar ist, dass der IQ nur eine von mehreren Vorbedingungen für den Erfolg in Schule und Beruf ausmacht. Andere Eigenschaften müssen dazukommen: Ausdauer, Durchsetzungswille, Ehrgeiz, Rücksichtslosigkeit ‒ nicht durchweg wünschenswerte Eigenschaften also. Und vielleicht auch Förderung und der reine glückliche Zufall. Der Chemiestudent, der sich im Labor die Augen verletzt, ist einer der vielen, denen ihr hoher IQ nichts einbringt, was sich in einer Erfolgsstatistik niederschlüge.

So kommt es, dass die Streuung der IQs in der Gesellschaftspyramide nach unten hin immer breiter wird und in den unteren Sozialschichten Menschen mit allen möglichen IQs zu finden sind, während "oben", bei den akademischen Berufen, die IQ-Streuung nur gering ist. Gerade darum sind es "gehobene" Berufe. Der IQ wirkt als eine Art Filter. Nach oben lässt er streng nur die mit einem höheren IQ durch; nach unten alle. Jeder kann Hilfsarbeiter sein, wenige aber Physiker; und manche, die aufgrund ihres IQs Physiker sein könnten, sind dennoch Hilfsarbeiter.

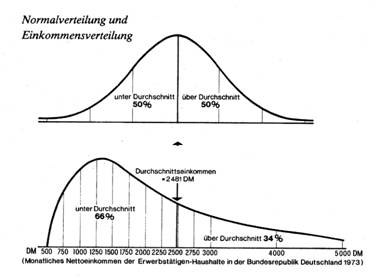

Was aber darüber gern übersehen wird: der hierarchische Aufbau der Gesellschaft ist keineswegs identisch mit der Intelligenz-Hierarchie. Nimmt man unsere sogenannte Leistungsgesellschaft beim Wort, so müßte "Tüchtigkeit" (ausgedrückt etwa durch ihren Faktor Intelligenz) belohnt werden (das heißt, wie die Dinge liegen, sich bezahlt machen). Intelligenz- und Einkommensverteilung müssten also ähnliche Kurven ergeben. Sie tun es nicht, wie eine simple Gegenüberstellung der beiden Kurven zeigt. (Die Einkommenskurve wurde auf Grund von Daten des Deutschen Instituts für Wirtschaftsforschung für 1973 gezeichnet, bezieht sich auf die Nettohaushaltseinkommen der Arbeiter, Angestellten, Beamten und Selbständigen und kann nur einen annähernden Eindruck geben.)

Anders als in der ideal symmetrischen IQ-Kurve liegt nicht die Hälfte, sondern liegen 66 Prozent der Geldverdiener unter dem Durchschnitt. Das Bild verrät, wie schief unsere Gesellschaftsordnung auch dann ist, wenn man sie nur beim Wort nimmt und an ihrer Devise "Leistungsgerechtigkeit" mißt.

Auch wenn die Leute sich wohl oder übel damit abfinden sollten, daß höhere Leistung belohnt werden muß (und noch ist, bei aller Grausamkeit des Konkurrenzdrucks, kein wirksameres und humaneres Mittel bekannt, den natürlichen Hang zur Bequemlichkeit zu überwinden und für die nötige Produktivität zu sorgen ‒ auch die kommunistischen Staaten offerieren Prämien und andere Leistungsanreize); selbst wenn sie das Ausmaß dieser materiellen Ungleichheit akzeptieren, das ja willkürlich ist (wird der Arzt den Arbeiter nur dann seinem Können entsprechend versorgen, wenn er zehnmal soviel verdient wie er, würde er es nicht auch für das Dreifache schon tun?): auch dann noch gibt es Grund genug für rebellische Stimmungen, denn "Intelligenz" als Voraussetzung höherer Qualifikation und materieller Erfolg entsprechen sich bisher durchaus nicht. Die unteren, das heißt hier nur: die unterdurchschnittlich verdienenden Ränge der Gesellschaft sind überbesetzt.

Nebenbei verrät diese Überbesetzung, daß hier noch ein großes, bisher unerschlossenes Intelligenzpotential liegen muss. Wenn Chancengleichheit verstanden wird als die Möglichkeit, daß gleich Begabte den gleichen sozioökonomischen Status erreichen, dann gibt es bisher noch lange keine Chancengleichheit. Dann darf man auch durchaus systemimmanent von Unterprivilegierten sprechen.

»Kulturfaire und kulturunfaire Tests: Beispiele